Las aplicaciones de IA para salud mental pueden ofrecer una forma económica y accesible de cubrir las necesidades del saturado sistema de salud mental estadounidense, pero los expertos en ética advierten que debemos ser cuidadosos con su uso, especialmente con los niños.

El acceso a la atención de salud mental puede ser difícil en EE. UU. La cobertura de seguros es deficiente y no hay suficientes profesionales de la salud mental para cubrir las necesidades del país, lo que genera largas esperas y costosas atenciones.

Aparece la inteligencia artificial (IA).

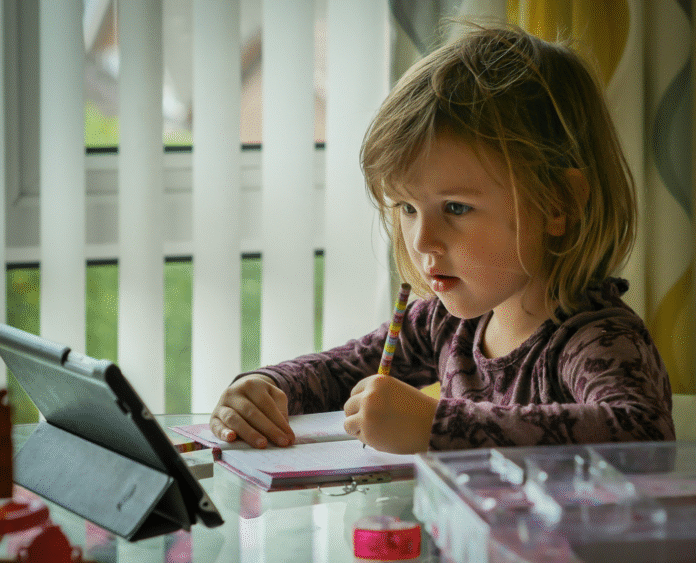

Las aplicaciones de IA para salud mental, desde rastreadores de estado de ánimo hasta chatbots que imitan a terapeutas humanos, están proliferando en el mercado. Si bien pueden ofrecer una forma económica y accesible de cubrir las necesidades de nuestro sistema, existen preocupaciones éticas sobre la excesiva dependencia de la IA para la atención de la salud mental, especialmente en el caso de los niños.

La mayoría de las aplicaciones de salud mental con IA no están reguladas y están diseñadas para adultos, pero existe un creciente debate sobre su uso con niños. Bryanna Moore, PhD, profesora adjunta de Humanidades de la Salud y Bioética en el Centro Médico de la Universidad de Rochester (URMC), quiere asegurarse de que estas conversaciones incluyan consideraciones éticas.

“Nadie habla de las diferencias en los niños: cómo funcionan sus mentes, cómo se integran en su núcleo familiar, cómo su toma de decisiones es diferente”, afirma Moore, quien compartió estas preocupaciones en un comentario reciente en el Journal of Pediatrics. “Los niños son particularmente vulnerables. Su desarrollo social, emocional y cognitivo simplemente se encuentra en una etapa diferente al de los adultos”.

De hecho, los chatbots de salud mental con IA podrían perjudicar el desarrollo social de los niños. La evidencia muestra que los niños creen que los robots tienen “valor moral y vida mental”, lo que plantea la preocupación de que los niños, especialmente los pequeños, puedan apegarse a los chatbots a costa de construir relaciones saludables con las personas.

El contexto social de un niño (sus relaciones con la familia y los compañeros) es fundamental para su salud mental. Por eso, los terapeutas pediátricos no tratan a los niños de forma aislada. Observan las relaciones familiares y sociales del niño para garantizar su seguridad e incluir a los familiares en el proceso terapéutico. Los chatbots de IA no tienen acceso a esta importante información contextual y pueden perder oportunidades de intervenir cuando un niño está en peligro.

Los chatbots de IA, y los sistemas de IA en general, también tienden a agravar las desigualdades sanitarias existentes.

“La IA solo es tan buena como los datos con los que se entrena. Para construir un sistema que funcione para todos, es necesario utilizar datos que los representen a todos”, afirmó el coautor del comentario, Jonathan Herington, PhD, profesor adjunto de los departamentos de Filosofía y de Humanidades de la Salud y Bioética. “Desafortunadamente, sin un esfuerzo minucioso para crear conjuntos de datos representativos, estos chatbots de IA no podrán atender a todos“. El género, la raza, la etnia, el lugar de residencia y el nivel de riqueza de la familia influyen en el riesgo de experimentar eventos adversos en la infancia, como abuso, negligencia, encarcelamiento de un ser querido o presenciar violencia, abuso de sustancias o enfermedades mentales en el hogar o la comunidad. Los niños que experimentan estos eventos tienen mayor probabilidad de necesitar atención intensiva de salud mental y menor probabilidad de acceder a ella.

“Los niños con menos recursos pueden no poder costear la terapia presencial y, por lo tanto, recurren a estos chatbots de IA en lugar de la terapia presencial”, afirmó Herington. “Los chatbots de IA pueden convertirse en herramientas valiosas, pero nunca deben reemplazar la terapia presencial”.

La mayoría de los chatbots de terapia con IA no están regulados actualmente. La Administración de Alimentos y Medicamentos de EE. UU. solo ha aprobado una aplicación de salud mental basada en IA para tratar la depresión mayor en adultos. Sin regulaciones, no hay forma de protegerse contra el uso indebido, la falta de informes o la desigualdad en los datos de entrenamiento o el acceso de los usuarios.

“Hay muchas preguntas abiertas que no se han respondido ni articulado con claridad”, afirmó Moore. No abogamos por la eliminación de esta tecnología. No decimos que debamos deshacernos de la IA ni de los bots terapéuticos. Decimos que debemos ser cuidadosos con su uso, especialmente cuando se trata de una población como la infantil y su atención de salud mental.

Moore y Herington colaboraron con la Dra. Serife Tekin, profesora asociada del Centro de Bioética y Humanidades de SUNY Upstate Medical, para este comentario. Tekin estudia la filosofía de la psiquiatría y las ciencias cognitivas, así como la bioética del uso de la IA en medicina.

En el futuro, el equipo espera colaborar con desarrolladores para comprender mejor cómo desarrollan chatbots terapéuticos basados en IA. En particular, desean saber si los desarrolladores incorporan consideraciones éticas o de seguridad en el proceso de desarrollo y cómo lo hacen, y en qué medida sus modelos de IA se basan en la investigación y la interacción con niños, adolescentes, padres, pediatras o terapeutas.

Fuente del artículo:

Materiales proporcionados por el Centro Médico de la Universidad de Rochester. Autor original: Susanne Pallo. Nota: El contenido puede ser editado por motivos de estilo y extensión.

Referencia de la revista:

Bryanna Moore, Jonathan Herington, Şerife Tekin. La Integración de Chatbots de Psicoterapia con Inteligencia Artificial en la Atención Pediátrica: ¿Andamiaje o Sustituto? The Journal of Pediatrics, 2025; 280: 114509 DOI: 10.1016/j.jpeds.2025.114509

Citar esta página:

Centro Médico de la Universidad de Rochester. “Mi robot terapeuta: La ética de los chatbots de IA para la salud mental infantil”. ScienceDaily. ScienceDaily, 31 de marzo de 2025. <www.sciencedaily.com/releases/2025/03/250331151256.htm>.